Бот судья: чем грозит применение искусственного интеллекта в судах

Созданный в Колумбии судебный прецедент использования чат-бота ChatGPT заставляет задуматься о новых рисках для правосудия. Конечно, остановить развитие технологий нельзя, но, по мнению адвоката и автора Телеграм-канала «Законы города Китежа» Александра Пиховкина, важно сформулировать условия, направления и границы применения ИИ в судопроизводстве.

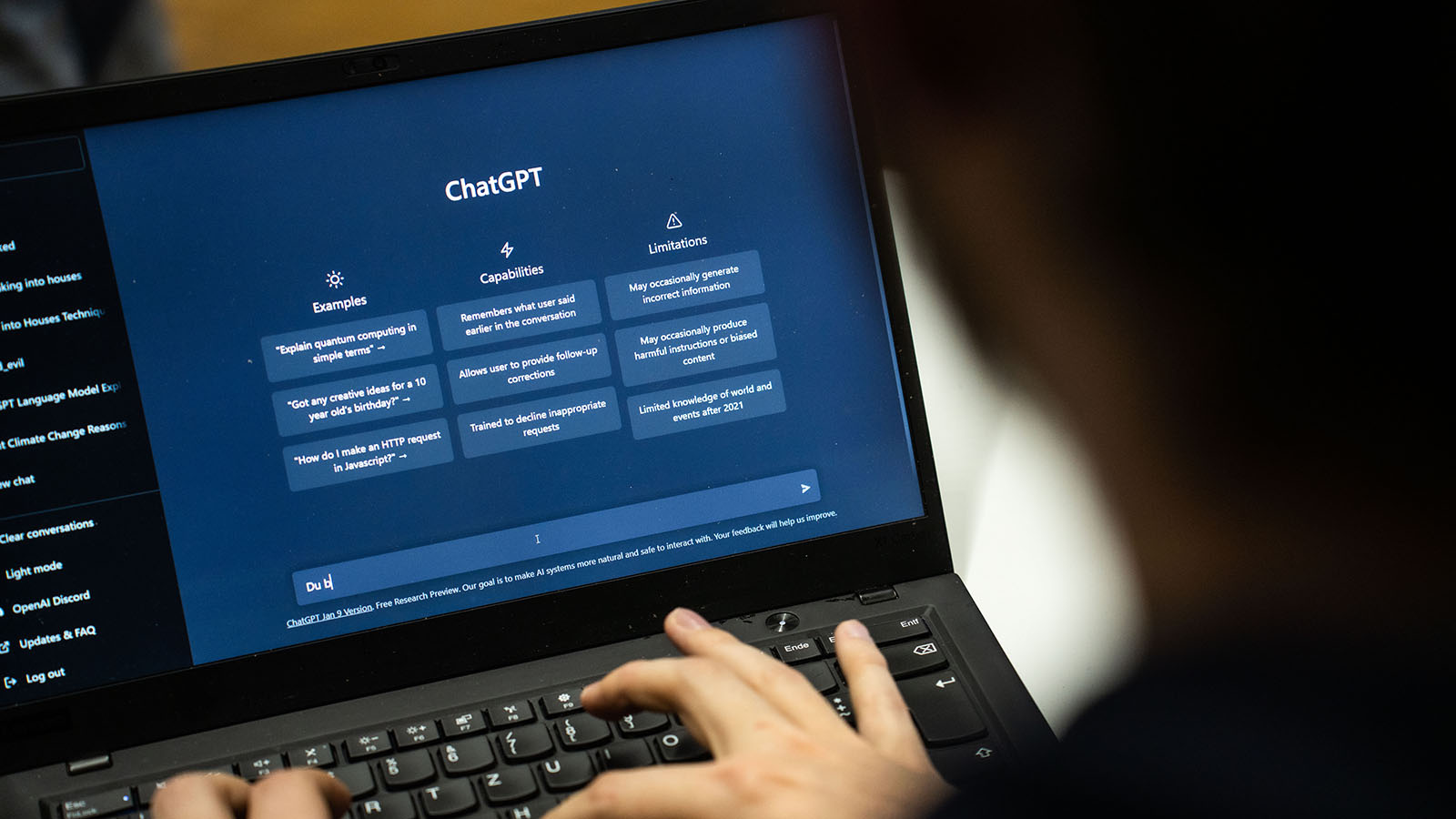

Популярный чат-бот ChatGPT впервые был использован при вынесении судебного решения. В конце января 2023 года в колумбийском городе Картахена судья обратился к искусственному интеллекту (ИИ) при вынесении решения о компенсации выплат по страховке. Семья страдающего аутизмом ребенка обратилась в суд с требованием признать, что медицинская страховка покрывает ее расходы на лечение мальчика. Чат-бот сформулировал для судьи решение, снабдив его ссылками на практику и разъяснения местного Верховного суда. Иск семьи был удовлетворен.

Судья Хуан Мануэль Падилья Гарсия заявил, что в конце концов решение принимал он сам. Но только сам судья знает точный ответ на вопрос о том, кто раньше, он или ИИ, принял решение по делу. И перспектива того, что внутреннее убеждение судьи может формироваться машиной, не вызывает энтузиазма. Этим ставятся под угрозу базовые принципы судопроизводства.

Безотказный помощник

Из комментариев судьи следует, что он задал боту ряд вопросов, и ChatGPT выполнил работу, которую раньше делал секретарь суда. Падилья похвалил нового помощника за составление простого и хорошо структурированного текста, что может сэкономить «время реагирования» в системе правосудия.

Случайно или нет, колумбийский судья выбрал подходящий пример, чтобы анонсировать приход ИИ в правосудие. Иск об оплате лечения ребенка обращается к нашей человечности, способность к критическому мышлению при этом снижается. Судебное решение в пользу семьи в таком случае кажется справедливым, независимо от действительных обстоятельств дела, которые остаются нам неизвестны. Ведь судья не просто так обратился за помощью к чат-боту. Значит, у него самого были сомнения или, как минимум, вопросы относительно правильного разрешения спора.

То, что судья вступил в непредусмотренное нормами закона и этики взаимодействие с ИИ, составляет одну проблему. Другая проблема заключается в том, что судья сделал это посредством неверифицированного, неюридического, проприетарного (принадлежащего частной компании) продукта. Наконец, очевидно, что судья своими действиями послал сигнал своим коллегам во всем мире о том, что такое в принципе возможно. Он и сам не скрывает этого. По мнению Падильи, другие судьи последуют его примеру.

Вопрос, однако, в том, что, вероятно, далеко не все коллеги Падильи публично признают свое обращение к ИИ при отправлении правосудия. Сможет ли общество застраховаться от бесконтрольного вмешательства технологий в правосудие?