Модель ИИ Brain2Music превращает мысли в музыку

Исследователи из Google и Университета Осаки (Япония) разработали модель ИИ, которая получает на входе информацию об активности мозга и по ней восстанавливает музыку, которую слышит человек. ИИ пока не может воспроизвести музыку из "чистого воображения", но ученые уверены, что скоро композитору будет достаточно представить свое произведение, и ее партитура будет напечатана на принтере.

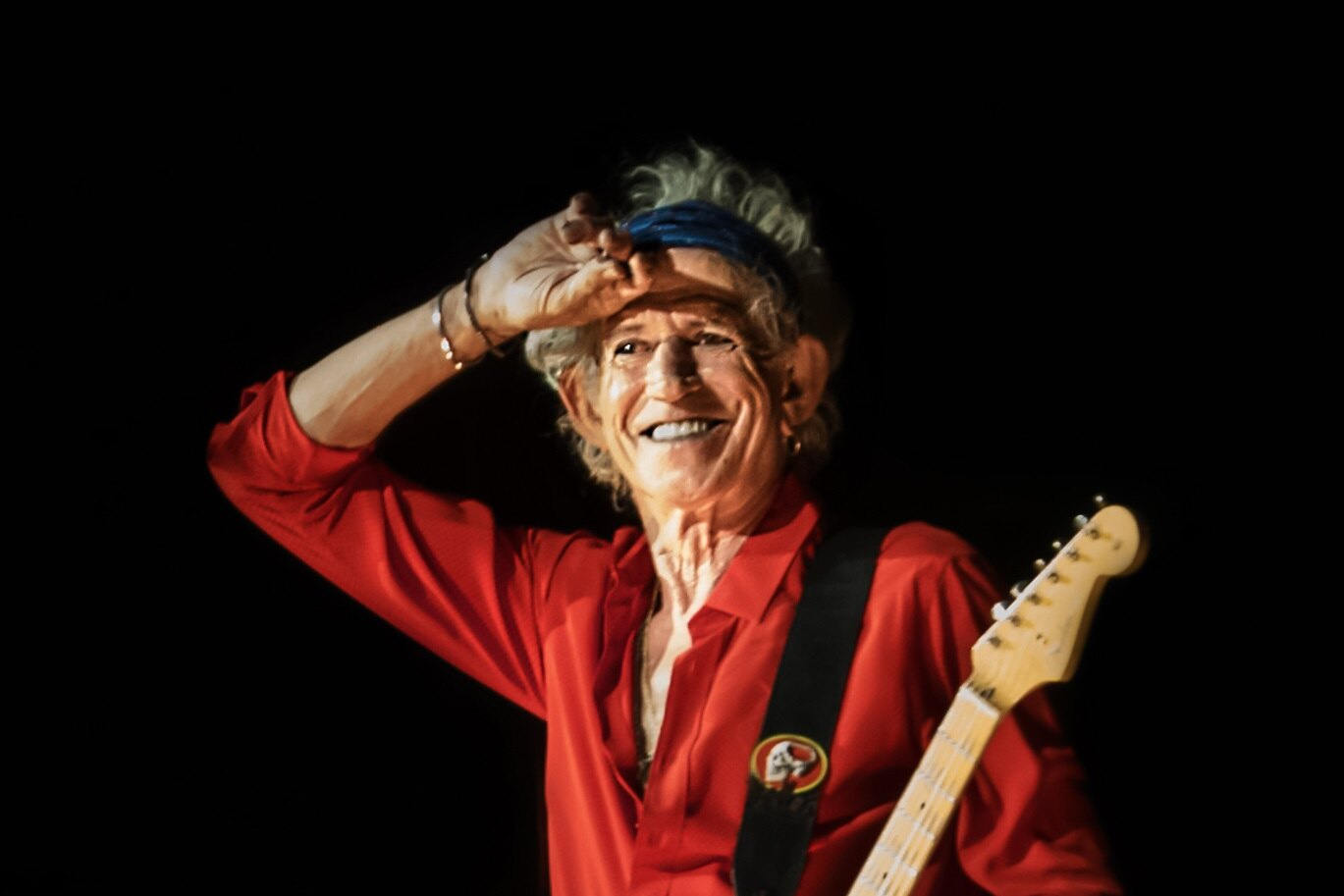

Легендарный гитарист Rolling Stones Кит Ричардс однажды сказал: "Музыка - это язык, который не выражается конкретными словами. Она говорит эмоциями, и если она в костях, то она в костях".

Кит Ричардс знает музыку, а исследователи из Google и Университета Осаки (Япония) знают активность мозга, и они сообщили об успехах в реконструкции музыки не по костям, а по мозговым волнам человека, наблюдаемым в при томографии.

Пятерым испытуемым проигрывались музыкальные образцы 10 жанров, включая рок, классику, металл, хип-хоп, поп-музыку и джаз, а исследователи наблюдали за их мозговой активностью. Показатели функциональной магнитно-резонансной томографии (фМРТ) записывались во время прослушивания. (Показатели фМРТ, в отличие от показателей МРТ, регистрируют метаболическую активность в реальном времени).